GenAI Security: Cloud Security fit machen für das KI-Zeitalter

Dieser Artikel wurde veröffentlicht in Zusammenarbeit mit Sopra Steria Ventures fördert strategische Kooperationen und Investitionen in Start-ups, um Innovationen in Bereichen wie generativer KI, Cybersicherheit, Nachhaltigkeit und Blockchain zu stärken. Es wird auch in Sopra Steria veröffentlicht Digital Excellence Website in deutscher Sprache, auf die zugegriffen werden kann hier.

Unternehmen, die auf KI aus der Cloud setzen, benötigen spezielle Sicherheitsstrategien (Cloud Security). Der Grund: Durch den Einzug von GenAI in die Cloud-Welt kommen neue Risiken hinzu. Hier ein Überblick über die Bedrohungslandschaft und die möglichen Gegenmaßnahmen.

Der KI-Markt wird sich bis 2028 verdoppeln, und viele Unternehmen wollen die Vorteile nutzen, speziell GenAI. Einige von ihnen können allerdings nicht problemlos auf Sprachmodelle und KI-Tools zugreifen. Cloud-Service-Anbieter machen deshalb GenAI-as-a-Service-Angebote, z. B. Amazon Bedrock, Azure AI Services und Google Vertex AI. Diese Angebote senken die Einstiegshürde drastisch und beschleunigen die Entwicklung, den Einsatz und die Wartung GenAI-basierter Anwendungen und Aufgaben, ohne dass sich Nutzer groß um die Infrastruktur und die Wissensanforderungen kümmern müssen.

Diese so genannten GenAI-Workloads wie Trainings von Modellen sind nicht frei von Sicherheitsrisiken, die entsprechend gemanagt werden müssen – siehe Anforderungen des EU-KI-Gesetzes. Unternehmen müssen die Risiken verstehen und sich mit möglichen Gegenmaßnahmen vertraut machen, um potenzielle Cloud-Angriffe abzuwehren und damit das Vertrauen ihrer Kunden zu erhalten. Und das sind, wie man sehen kann, eine ganze Menge.

Top-Bedrohungen gegen GenAI-Cloud-Workloads

LLM-Jacking

LLM-Jacking ist ein Angriff, bei dem sich Kriminelle illegalen Zugang zu Large Language Models (LLMs) verschaffen. Sie stehlen zunächst Cloud-Anmeldedaten, z. B. AWS-API-Schlüssel, und verwenden diese dann für den Zugriff auf GenAI-Cloud-Workloads, z. B. LLMs. Die Hauptmotivation besteht darin, die enormen Rechnungsbeträge, die bei den „Opferkonten“ anfallen (bis zu 46.000 US-Dollar LLM-Verbrauch pro Tag), an die Organisation weiterzuleiten. KrebsOnSecurity veröffentlichte kürzlich einen Bericht über LLM-Jacking-Angriffe, der auf einer von Permiso Security durchgeführten Untersuchung basiert. Der Bericht zeigt, wie lukrativ LLM-Jacking für Cyberkriminelle ist. Eine prominente cyberkriminelle Organisation, die hinter diesem Angriff stand, erwirtschaftete über ein Geschäftsmodell, das den Weiterverkauf von Sex-Chatbots beinhaltet, einen Jahresumsatz von einer Million US-Dollar. LLM-Jacking wurde erstmals Anfang des Jahres vom Sysdig Threat Research Team gemeldet.

Data Poisoning (Datenverfälschung)

Data-Poisoning-Angriffe sind bösartige Aktionen, bei denen Angreifer bösartige oder unsinnige Daten in die Trainingsdatensätze einspeisen, um die von LLMs erzeugten Ergebnisse zu verfälschen. Daten sind das Herzstück von GenAI. Trainings- und Feinabstimmungsdaten müssen für GenAI-Cloud-Workloads leicht zugänglich sein, um eine Anpassung und Kontextualisierung über Retrieval-Augmented-Generation-(RAG-)Techniken zu ermöglichen.

Die von CSPs zur Verfügung gestellten LLMs sind in der Regel vortrainiert und universell einsetzbar. Dies reduziert zwar den Trainingsaufwand und die benötigten Ressourcen, allerdings müssen die Antworten der Modelle angepasst werden, um die spezifischen Anwendungsfälle der Unternehmen zu erfüllen. Feinabstimmungsdaten werden jedoch in der Regel in so genannten S3-Buckets gespeichert, wodurch die Daten für Data-Poisoning-Angriffe anfällig sind; Angreifer sind mit den S3-Schwachstellen vertraut.

Exfiltration von Daten

Ähnlich wie bei den Data-Poisoning-Angriffen sind die von GenAI-Cloud-Workloads verwendeten Daten attraktive Ziele für Exfiltrationsangriffe. Es gibt mehrere Gründe, warum Angreifer eher an Trainingsdaten als an anderen Datentypen interessiert sind. Der Hauptgrund ist die Notwendigkeit, an geschützte Informationen oder geistiges Eigentum zu gelangen. Der Zugang zu geistigem Eigentum könnte Wettbewerbern einen erheblichen Vorteil verschaffen.

Prompt-Injektion

Prompt-Injection-Angriffe sind einer der am häufigsten diskutierten Bedrohungsvektoren gegen LLMs. Angreifer erstellen dafür bösartige Eingabeaufforderungen, die LLMs zu unbeabsichtigten Handlungen verleiten. Dazu zählt z. B. die Preisgabe vertraulicher Informationen. Prompt Injection findet in der Anwendungsschicht statt. Ähnlich wie bei anderen Angriffen gibt es Auswirkungen und Herausforderungen, wenn Anwendungen in der Cloud bereitgestellt werden. Angesichts der Notwendigkeit, GenAI-Anwendungen zu skalieren, würden Unternehmen aus Gründen der Ausfallsicherheit und Skalierbarkeit eine zentrale Verwaltung von GenAI-Anwendungen vorziehen. Dies würde letztlich bedeuten, dass Soforteinspeisungsangriffe eher auf die Infrastruktur als auf die Anwendungsschicht abzielen.

Angriffe auf KI-/ML-Modelle

GenAI-Workloads in der Cloud können sowohl vom Anbieter als auch vom Kunden verwaltete Modelle für maschinelles Lernen (MLs) umfassen. Vom Anbieter verwaltete Modelle sind weniger anfällig für Angriffe, da die Anbieter zusätzliche Sicherheitsmaßnahmen implementieren und diese am wenigsten gefährdet sind. Vom Kunden verwaltete Modelle sind stärker gefährdet. Sie werden häufig in Container Image Repositories (z. B. Azure Container Registry), virtuellen Maschinen oder Kubernetes-Clustern gespeichert. Mehrere ML-Image-Angriffsvektoren sind im MITRE ATLAS dokumentiert, darunter Backdoor ML Model, Full ML Access, Evade ML Model und Erode ML Model Integrity. Mehrere dieser Modellangriffe wurden kürzlich von Wiz Research gegen SAP AI Core aufgedeckt.

Cloud-Fehlkonfiguration

Die meisten Cloud-Angriffe sind auf falsch konfigurierte Cloud-Ressourcen und Fehler der Kunden zurückzuführen. GenAI-Cloud-Workloads sind von dieser Bedrohung nicht ausgenommen. Betroffen sind das Identitäts- und Zugriffsmanagement (IAM), die Verschlüsselung und das Geheimnismanagement. Jede Art von Fehlkonfiguration kann erhebliche Sicherheitsauswirkungen auf GenAI-Workloads haben und zu erfolgreichen Angriffen führen.

Umgang mit Bedrohungen gegen GenAI-Workloads

Mehrere Bedrohungen gegen GenAI-Cloud-Workloads sind bekannt, und es gibt bereits Strategien zur Eindämmung. Viele dieser Bedrohungen sind jedoch KI-spezifisch und erfordern neuartige Abhilfestrategien. Im Folgenden werden zwei dieser wesentlichen Strategien zur Sicherung von GenAI-Cloud-Workloads untersucht.

AI Security Posture Management

Es gibt verschiedene Ansätze für das Sicherheitsmanagement, darunter Cloud Security Posture Management (CSPM) und Data Security Posture Management (DSPM). Diese Ansätze decken die KI-spezifischen Lücken in Cloud-Umgebungen nur teilweise ab; daher ist ein spezifischer Ansatz erforderlich: AI Security Posture Management (AISPM).

Mit AISPM können Unternehmen schnell auf falsch konfigurierte GenAI-Cloud-Workloads prüfen und sicherstellen, dass die besten Sicherheitsverfahren implementiert werden. Darüber hinaus können Unternehmen AISPM nutzen, um die Einhaltung gesetzlicher Vorschriften und Compliance-Anforderungen, wie z. B. des EU-KI-Gesetzes, zu überwachen und sicherzustellen.

KI-Red-Teaming

Obwohl sich mit AISPM verschiedene Sicherheitsmaßnahmen für GenAI-Workloads implementieren lassen, werden damit nicht alle Sicherheitsanforderungen erfüllt. Gemäß den Richtlinien für verantwortungsvolle KI müssen Unternehmen gewährleisten, dass diese sicher sind und keine toxischen, voreingenommenen, unangemessenen oder sachlich falschen Inhalte (Halluzinationen) generieren. Hier bietet sich AI Red Teaming an, diese Anforderungen durch strenge Tests von GenAI-Workloads zu erfüllen.

Sichere und verantwortungsvolle KI mit Sopra Steria und Mitigant

Cloud Security und speziell GenAI Security sind wichtige Bausteine, um sichere und verantwortungsvolle KI zu entwickeln und zu betreiben.

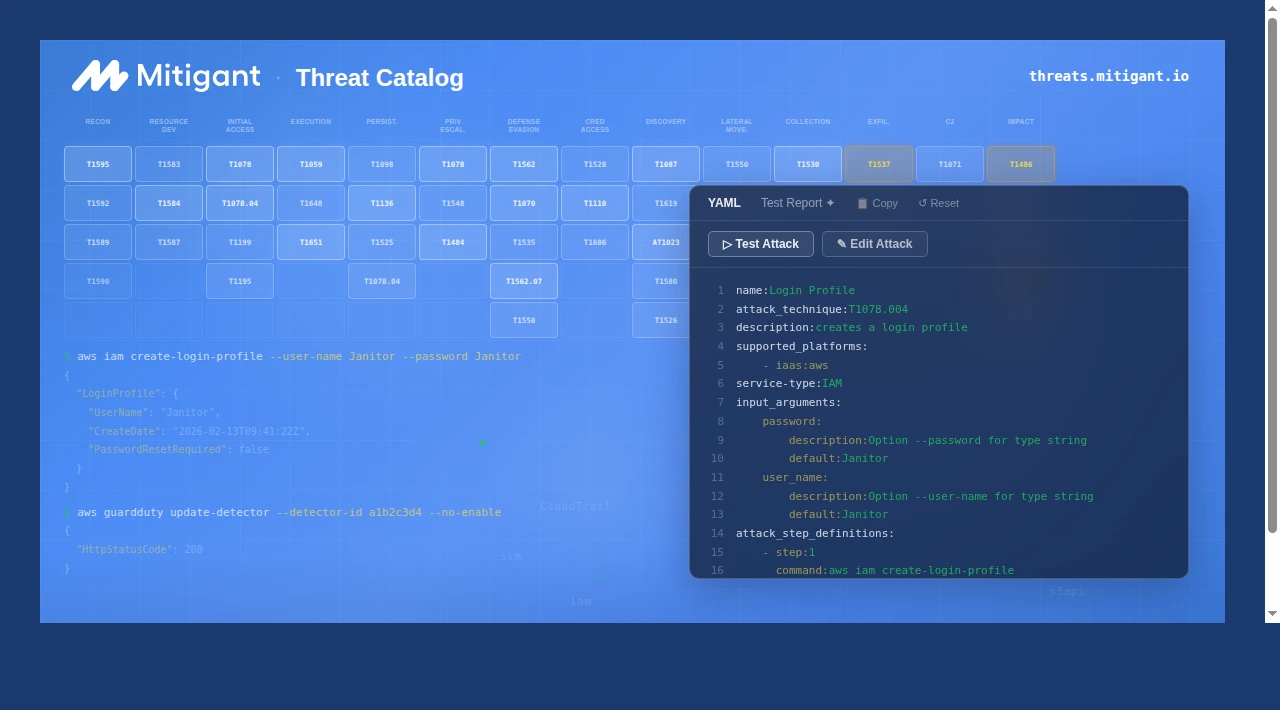

Mitigant ist ein innovatives Startup, das die Grenzen der Cloud Security auslotet, einschließlich aller Aspekte im Zusammenhang mit GenAI-Cloud-Workloads. Mehr über uns: https://mitigant.io/sign-up

Sopra Steria Ventures bringt als Venture-Unit von Sopra Steria Start-up-Innovationen und KI-nutzende Unternehmen zusammen. Als führende europäische Management- und Technologieberatung bietet Sopra Steria umfassende Erfahrung in der Entwicklung und Umsetzung von KI-Strategien mit und macht Cybersecurity-Strategien ihrer Kunden fit für das KI-Zeitalter.

.png)